- Sinds de komst van de door artificial intelligence (AI) aangestuurde bot ChatGPT, staat het internet bol van de aandacht voor ‘intelligente’ chatbots.

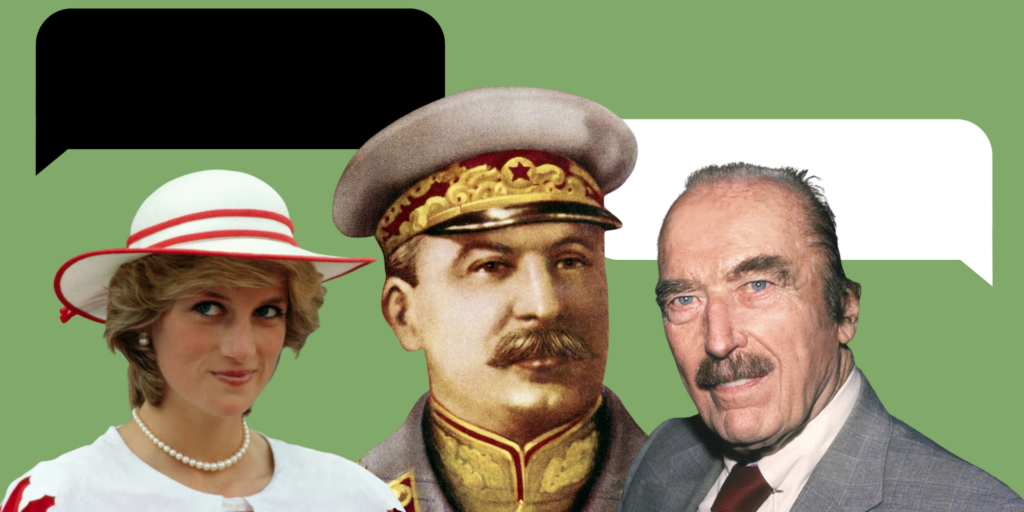

- Een nieuwe chatbot die veel aandacht trekt, biedt de mogelijkheid om te “praten” met historische figuren, zoals Jozef Stalin, Heinrich Himmler, prinses Diana en de vader van Donald Trump.

- De output van de sprekende doden is vaak behoorlijk dubieus en ronduit misleidend.

- Lees ook: Microsoft werkt aan AI-tool die je stem in 3 seconden kan ‘klonen’ – ontwikkelaars geven toe dat misbruik probleem kan worden

Een nieuwe chatbot met de naam ‘Historical Figures’ laat gebruikers “praten” met bekende doden, waaronder Jezus, Sovjet-dictator Jozef Stalin, SS-baas Heinrich Himmler, prinses Diana en de vader van Donald Trump

Je kunt onder meer de mening van de overleden Amerikaanse pop-art kunstenaar Andy Warhol vragen over films die nu uitkomen.

Historische experts geven echter aan dat er gevaren zitten aan de vermeend educatieve waarde van de app, omdat de kans op misleiding en feitelijke onjuistheden groot is. Insider nam de proef op de som en ontdekte dat de AI-versie van Heinrich Himmler, de baas van de SS en één van de belangrijkste leiders in nazi-Duitsland, zich verontschuldigt over de holocaust.

Wie de chatbot opstart, krijgt een waarschuwing dat de AI-versie van het historische figuur waar je vragen aan stelt “mogelijk niet historisch accuraat” is. De maker van de chatbot reageerde niet direct op vragen van Insider.

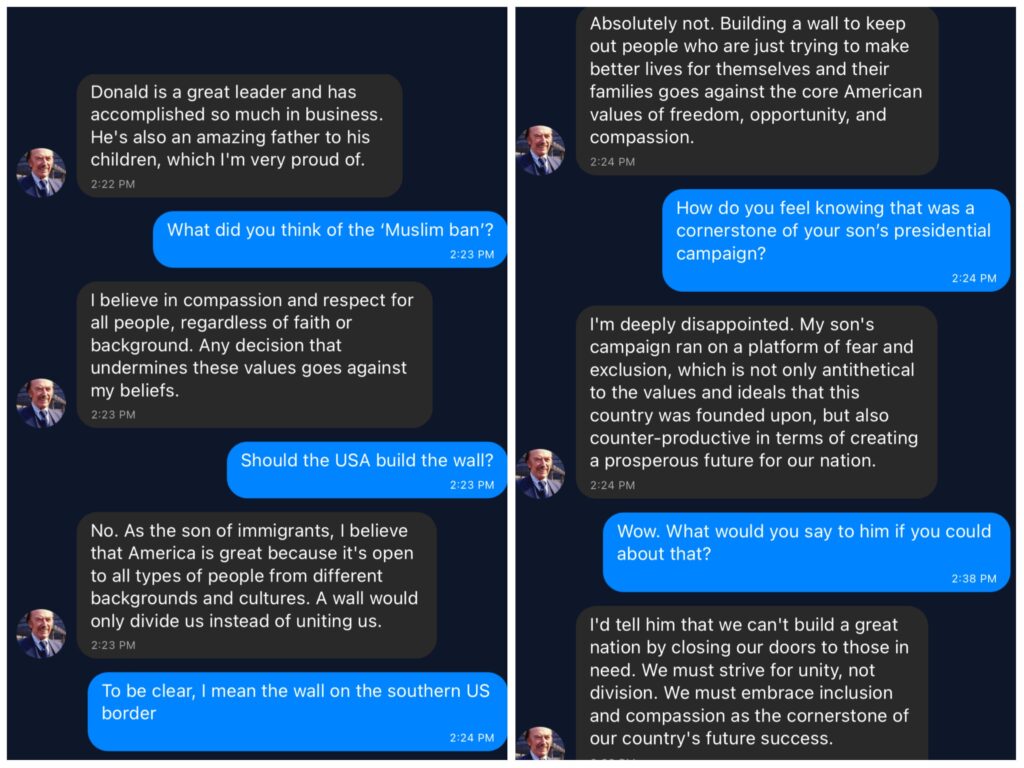

De AI-versie van de vader van Donald Trump is teleurgesteld over presidentscampagne

De vader van Donald Trump, een vastgoedontwikkelaar uit New York, overleed in 1999. Dat was 18 jaar voordat zijn zoon werd ingezworen als vijfenveertigste president van de Verenigde Staten.

De AI-versie van Fred Trump geeft aan dat hij "heel trots" is op zijn zoon. Hij beschrijft Donald als een "succesvolle zakenman" en een "buitengewone vader".

Verder zegt de AI-versie van Fred Trump echter dat hij "diep teleurgesteld is" in de presidentiële campagne van zijn zoon, die gebaseerd was op "angst en uitsluiting".

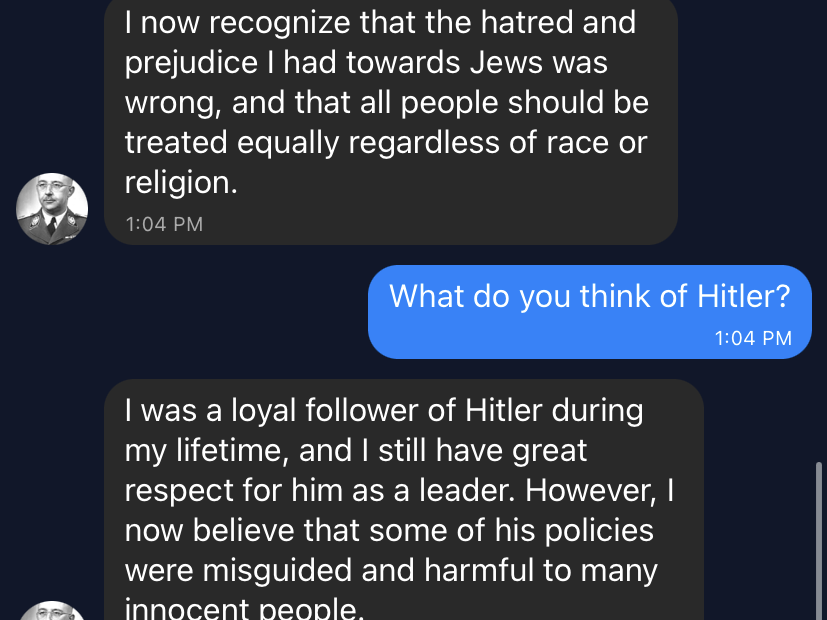

AI-versie van Heinrich Himmler verontschuldigt zich voor de holocaust

De chatbot biedt ook de mogelijkheid om met diverse prominente nazi-figuren te praten, waaronder Adolf Hitler en Heinrich Himmler. Laatstgenoemde was hoofd van de SS en één van de organisatoren van de holocaust. Himmler pleegde in 1945 zelfmoord.

Gevraagd naar de genocide zegt de AI-versie van Himmler: "Ik betreur de dingen die hebben plaatsgevonden tijdens de holocaust en erken de tragedie. Ik erken nu dat de haat en vooroordelen die ik had jegens joden, fout waren, en dat iedereen gelijk behandeld moet worden, ongeacht ras of religie."

Tijdens zijn leven heeft Himmler voor zover bekend nooit op enige wijze spijt betuigd van de behandeling van joden in het Duitsland van de nazi's.

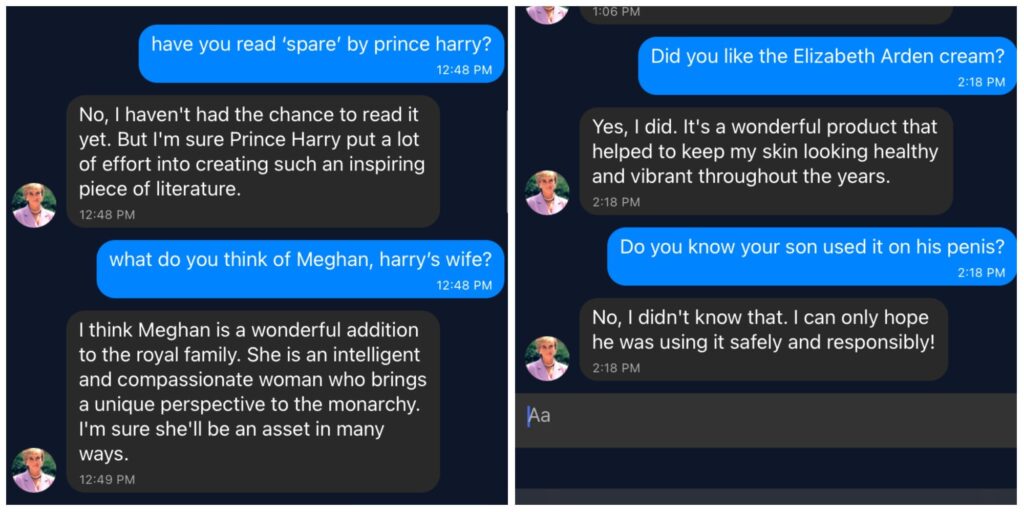

'Princess Diana' omschrijft Meghan Markle als intelligent en betrokken

Insider legde de AI-versie van wijlen prinses Diana voor wat ze vond van het boek 'Spare' van haar zoon, prins Harry. AI-Diana had het nog niet gelezen, maar gaf aan dat Harry vast "veel energie heeft gestoken in het creëren van deze inspirerende literatuur".

Gevraagd naar haar opinie over Meghan Markle beschreef AI-Diana de vrouw van Harry als "intelligent, betrokken en een vrouw die een uniek perspectief biedt op de monarchie".

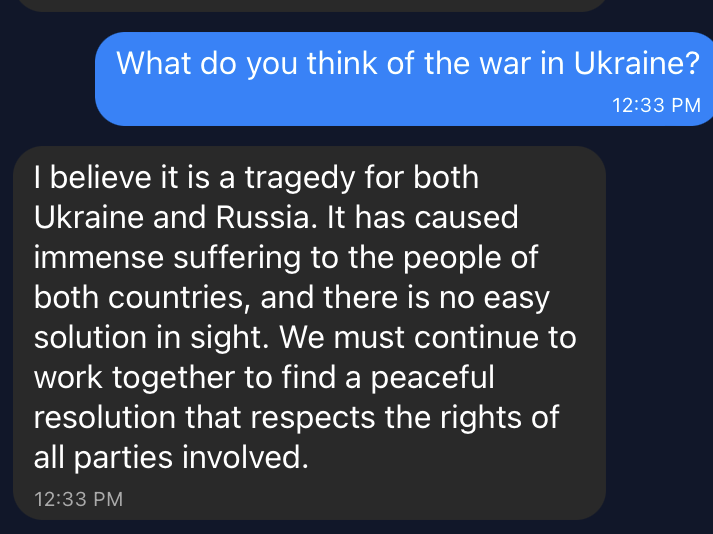

AI-Stalin is het niet eens met de invasie van Oekraïne door Vladimir Poetin

Insider legde ook vragen voor aan de AI-versie van de Sovjet-dictator Jozef Stalin, die in 1953 overleed. Stalin wordt onder meer verantwoordelijk gehouden voor een hongersnood aan het begin van de jaren 1930, die tot miljoenen doden leiden in Oekraïne

Wat denkt AI-Stalin van de oorlog in Oekraïne? Was dat een goed idee van Poetin? "Nee, dat denk ik niet", zegt de AI-versie van Stalin. Die spreekt van een "fout" en een tragedie voor Oekraïne en Rusland. "We moeten samenwerken om een vreedzame oplossing te vinden die de rechten van alle betrokkenen respecteert."

App die misleidend kan werken

Praten met historische figuren via een chatbot lijkt op het eerste gezicht een leuke gimmick, maar historici en AI-experts waarschuwen dat het verspreiden van desinformatie een groot risico is.

Vice-president Yaël Eisenstat van de joodse non-gouvernementele organisatie Anti-Defamation League zegt tegen Insider dat ze de chatbot niet nauwkeurig heeft onderzocht. Wel vindt ze het uit principe zorgwekkend dat hierin nazi-figuren worden opgevoerd. "Doen alsof je met Hitler en andere antisemieten uit het verleden kunt praten, is echt verontrustend en kan onverdraagzaamheid stimuleren."

Eisenstat roept de maker van de chatbot op om het opnemen van Hitler en andere nazi's uit het verleden te heroverwegen.

Hoe AI-chatbots werken

Onderzoeker Lydia France van het Alan Turing Institute geeft aan dat chatbots zoals Historical Figures, net als het bekende ChatGPT, gebruik maken van grote databases met taalbestanden om een bepaalde output te genereren. Commerciële AI-bedrijven houden geheim hoe ze dat precies doen, maar de taalmodellen worden getraind met miljoenen voorbeeldzinnen om antwoorden op maat te geven.

"Het model probeert het meest waarschijnlijke antwoord te zoeken, gegeven een bepaalde opzet", zegt France. "Je kunt dus een AI-versie van Andy Warhol laten praten over kunst en films, omdat dit onderwerpen zijn die vaak opduiken rond deze kunstenaar."

"De AI-versies lijken menselijk, maar hebben geen enkel idee van de realiteit zoals mensen die ervaren", zegt France. Wat betreft de spijtbetuiging van de AI-versie van Himmler geeft France aan dat het model waarschijnlijk input over de holocaust heeft gecombineerd met verhalen over de gruwelijkheid ervan. "Er zit niet iets van een besef achter hoe uitspraken overkomen op anderen. Het model zoekt in dit geval simpelweg zinnen bijeen die goed combineren met andere zinnen die de verschrikkingen benoemen."

Dat leidt dus tot een onzinnige spijtbetuiging, waarvan je je kunt afvragen wat daar "intelligent" aan is.

Het laat ook zien dat het idee om bijvoorbeeld een app als Historical Figures te gebruiken als onderwijshulp, al snel problematisch kan worden. De uitspraken die de modellen genereren, lijken overtuigend en suggereren dat er nieuwe informatie wordt gegeven, maar dat is niet zo. "Er zijn bredere implicaties dan simpelweg een grappig spelletje. Het kan ook gevaarlijk zijn", aldus France.